前言

“爬虫写得好,牢饭吃得早”。在一次面向科技企业的法律讲座中,意外发现到场的听众里,技术同学比法务同学多。那一期我主讲爬虫数据合规的法律边界。互动环节,提问热情高涨。听众的注意力,普遍集中在如下三点:第一,使用爬虫是否违法,会不会坐牢(承担刑事责任)。第二,员工可否以职务行为之名甩锅给公司(承担责任的主体)。第三,企业基于爬虫技术的商业模式是否合规。

爬虫出现的语境和业务场景,容易让人误以为这是一种违法技术,实则不然。作为数据流通的一种机制,数据爬取的历史和争议,伴随着互联网技术一路发展。正如美国 Sandvig v. Sessions 案的判决书所言:爬取只是数字时代更便利的信息收集工具,它与使用录音机而不是记笔记,或者使用智能手机的全景摄像而不是用传统相机别无二致。

本次网络爬虫的数据合规专题,我们将通过四篇文章,对如下问题进行分析探讨,并提供实务操作建议:

1.爬虫协议和数据爬取行为的法律性质为何?

2.现行法律法规对网络爬虫的监管规制有哪些?

3.如何平衡竞争性利益保护和开放互联网之公共利益?

4.企业使用爬虫技术的行为合规边界为何?

本文为第一篇,分析爬虫协议的定性和数据爬取行为的法律性质。

(一)

爬虫协议的概念

网络爬虫(Web robots),亦称网络机器人或网页蜘蛛,系按照一定的规则,自动抓取网络信息的程序或者脚本。作为一种自动提取网页的程序,它是搜索引擎的重要组成部分。爬虫协议(Robots Exclusion Protocol),又称为机器人协议或Robots协议,是指互联网站所有者使用robots.txt文件,向网络爬虫给出网站指令的文本文档,多应用于网络内容服务商(Internet Content Provider,ICP)的服务器,用于指导搜索引擎,是否允许或禁止爬虫抓取某一具体的网站内容或网页,并将其作为搜索结果提供给用户。换言之,爬虫协议就是告知网站如何应对网络爬虫的“行为指南”。

由此可见,爬虫协议并非法律意义上的协议或合同,其并非由协议各方协商一致进行意思表示所缔结,也不具有强制约束力。按照《互联网搜索引擎服务自律公约》约定,各签约方遵循robots协议,对于违反公约内容的,相关网站应及时删除、断开链接。

在协议文本的表现形式上,爬虫协议通常由一个或多个语法单元组成,每个语法单元可分为两部分:一个是User-agent值,用于设置其允许或禁止的搜索引擎,后接其所针对的爬虫程序的具体命名;另一个则是Allow或Disallow值,用于设置特定搜索引擎所能访问或禁止访问的内容。以下是某网站的爬虫协议示例。

-

某制造网Robots协议示例

User-agent: *

Disallow: /*.do$

Disallow: /*.do?

Disallow: /*.action$

Disallow: /*.action?

Disallow: /sendInquiry/

Disallow: /browsing-history/

Disallow: /advanced-search/

Disallow: /member/

Disallow: /rss/

Disallow: /ad?url=

Disallow: /cs/

Disallow: /products-search/find-china-products/*-1.html

Disallow: /errorDocs/

Disallow: /multi-search/

Disallow: */recommend/alsoLiked/*

Disallow: /showroom/*/prod-question-count

Disallow: /dt/

Disallow: /join/?sourceType

Disallow: /start-order.html?from=

Disallow: /go/

Disallow: /company-search/

User-agent: SemrushBot

Disallow: /

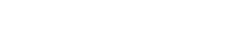

图1 某网站的爬虫协议示例

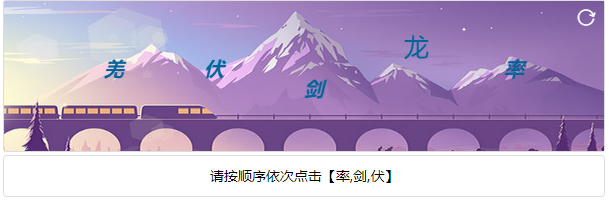

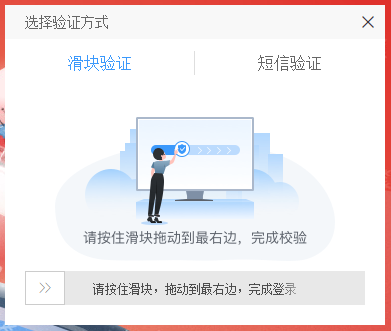

除了爬虫协议以外,网站还可能采取相应的反爬虫技术措施,例如身份校验、访问频率限制、验证码、用户登录等。《数据安全法》第三十二条规定,任何组织、个人收集数据,应当采取合法、正当的方式,不得窃取或者以其他非法方式获取数据。绕行或强行突破网站设置的反爬虫技术措施,亦将可能承担相应的法律责任。

图2 验证信息属于最常见的反爬虫措施之一

(二)

爬虫协议的性质

作为一种单方宣示意义上的行为指南,爬虫协议具有区别于一般合同的典型特征。作为一种技术规范,其作用仅在于标示该网站是否准许爬虫访问、准许哪些爬虫访问,但爬虫识别该协议后,无论是否遵守,爬虫协议都不会起到强制禁止访问的结果。

在学理层面,有学者提出爬虫协议具有三个特征:其一,技术性,是由搜索引擎中的计算机软件所识别、阅读的技术文档,基本功能是解决技术问题,而非分配权利义务;其二,非强制性,其存在或生效与否,不影响网站信息的公开,也不会对搜索引擎的访问行为带来技术上的障碍;其三,竞争性,相关各方主体往往将其用作竞争工具。有学者进一步指出,爬虫协议在法律定性上系权利声明或单方意思表示,它是ICP等数据控制方的单方意思表示,必须与某种具体的实体权利相结合并以之为依托方可充分发挥其作用,脱离该实体权利的爬虫协议将丧失其针对爬虫程序的效力。

在实务层面,北京市第一中级人民法院曾在百度公司诉奇虎公司不正当竞争纠纷案中,对爬虫协议的性质做出如下评述:

第一,技术规范。Robots协议虽然名为“协议”,但仅是一种网站程序编写的技术规范,旨在通过程序代码标示是否准许搜索引擎爬虫机器人访问、准许哪些搜索引擎爬虫机器人访问,其并非法律意义上的协议或者合同。

第二,单方宣示。Robots协议是由网站服务商或所有者在编写网站程序时自行编写,并不事先征求搜索引擎服务商或网络用户的意见,其具体内容并非网站服务商或所有者与搜索引擎服务商达成的一致。

第三,非技术措施。Robots协议作为一种技术规范,其作用只在于标示该网站是否准许搜索引擎爬虫机器人访问、准许哪些搜索引擎爬虫机器人访问,但爬虫机器人识别该Robots协议的内容后,无论爬虫机器人是否遵守,Robots协议都不会起到强制禁止访问这一技术措施的作用。

第四,普遍遵守。在Robots协议出现的上世纪九十年代,由于互联网刚刚出现,只有较少的技术人员掌握互联网技术,所以当上述技术人员提出和发起了Robots协议的时候,相当于形成了本领域内的行业共识。时值今日,虽然互联网技术已经极大普及,但作为一种对本领域技术人员通俗易懂、操作简便的技术规范,Robots协议已经成为了一种国内外互联网行业内普遍通行、普遍遵守的技术规范,国内外由于搜索引擎拒绝遵守Robots协议而引起的纠纷甚为少见。

在具体操作方面,网站服务商或所有者可以在Robots协议中列明准许其爬虫机器人访问的名单,其他爬虫机器人均不许访问,即白名单制度;亦可列明不准其爬虫机器人访问的名单,其他爬虫机器人均可以访问,即黑名单制度。

在数据处理活动中,数据流通机制通常包含两种路径:一是多方基于合同安排,通过“开放应用端口”(open API)进行的数据共享;二是一方通过爬虫软件自动抽取他方数据库数据,其表现为“网页抓取”(web scraping)、“屏幕抓取”(screen scraping)等数据爬取形式。

数据爬取作为数据流通的一种手段,行为本身不具备可责性。这不仅仅是“技术中立”之说辞的万能解释,更重要的原因在于,蕴含于数据爬取中的——数据自由流通——是数字经济社会倡导的重要价值。作为一种新型生产要素,数据价值的发掘有赖于数量上的规模(volume)、类型上的多样(variety)和流通上的高速(velocity)。

进入超数据时代,大数据还表现出了新的特征。一是交织性(Hybrid)。数据碎片化分布在信息空间、物理世界和人类社会三元空间中,客观事物在不同空间留下了碎片化、不完整的数字足迹。为了全面刻画事物全貌,需要充分发掘和利用三元空间的交织性与互补性,对碎片化数据实现优质聚合。二是超维性(Hyper)。数据片段之间的关联关系空前复杂多变。在三元空间中,单一空间中的数据只能反映事物某一方面的特征,只有融合三元空间的关联数据,对各类数据、信息实现高效的整合,才能解决人类科学与知识探索中“盲人摸象”的问题。因而,数据自由流通原则已经被国际规则和各国法律所认可。我国《数据安全法》第七条亦明文规定“鼓励数据依法合理有效利用,保障数据依法有序自由流动”。

实务中,企业因数据爬取行为产生的争议解决,焦点不在于爬虫技术本身,而在于使用该技术突破行为正当性边界,进而可能产生的不正当竞争、侵害公民个人信息或者非法侵入计算机信息系统等问题中。

分析基于数据爬取行为产生的案件纠纷,常见的突破正当性边界的爬虫行为主要有:

其一,大量爬取并使用被爬取网站的相关信息,实质性地替代了被爬取网站向用户提供服务,对其造成实质损害,比如本章所示的关于点评网的数据爬取行为。

其二,抓取太快或过于频繁易导致被爬取网站拥堵,甚至服务器瘫痪,影响该网站正常运行和数据的顺畅流通。

其三,抓取网站管理后台等敏感数据,甚至会爬取到敏感个人信息或企业商业秘密。

其四,抓取行为对网上投票、订票业务等场景造成冲击,出现虚假“刷票”或“黄牛”抢票等有违公平的结果。

回到数据爬取行为的定性上,作为一种单方的非合意的数据流通行为,其本身不具备违法性和可责性。正如最高人民法院在某技术秘密纠纷的判决书中所指出:“即使爬虫技术曾被用于违法活动,但并不等于该项技术本身具有违法性。”

由此可见,提到爬虫就想到坐牢,实属想当然的误解。但为何在网络爬虫的实务活动中,对其监管和法律规制往往伴随着法律责任的承担,甚至是刑事责任呢?这关乎我国现行法律框架下,对网络爬虫的法律规制方式,即基于竞争法、著作权法和刑法进行的规制。我们将在下一篇文章详细展开。

推荐阅读

2022年度广悦数据合规代表性业绩大盘点 | 奋楫扬帆 赓续前行

声明

本文仅为交流探讨之目的,不代表广悦律师事务所或其律师出具的任何形式之法律意见或建议。如需转载或引用本文的任何内容,请与本所沟通授权事宜,并于转载或引用时注明出处。如您有意就相关议题进一步交流或探讨,欢迎与本所联系。

作者简介

冯清清

高级合伙人

互联网与数字经济

互联网、公司股权、数据合规、私募基金与创业投资

中南财经政法大学合作硕士研究生导师

《亚洲法律杂志》ALB2023华南区律师新星

粤港澳全面合作法律事务专家咨询委员会科技创新组专家成员

广东省律师协会青年律师工作委员会委员

广州市律师协会文化传媒与体育娱乐法律专业委员会副主任

厦门大学广东校友会法律分会理事

fengqq@wjngh.cn

冯清清律师为广悦律师事务所高级合伙人,中南财经政法大学数字法学方向硕士研究生导师,获《亚洲法律杂志》“ALB 2023华南区域律师新星”。其带领团队主办数十个数据治理体系搭建及数据合规项目,覆盖新能源汽车、金融、医疗、科技、消费等行业;先后发表专业文章和实务指引120余篇,于威科法律数据库发布《科创板上市审核对企业数据合规的启示系列专题》等多个专业成果;主办《数字产品海外数据合规项目案例成果》获广州市律协“维护中方海外权益,广州律师在行动”表彰;参与编写出版实务专著《大数据时代企业数据合规之路》(法律出版社,2022)《数字经济时代企业股权实用指南》(机械工业出版社,2022);个人专著《新律师进阶之路——非诉业务的思维与方法》(中国法制出版社,2019)获广州市律协理论成果一等奖。

作者丨冯清清

编辑丨何雪雯

审核丨苏冰

审定丨品牌宣传与市场拓展委