“我好累啊,你能安慰我一下吗?”

“今晚你不需要变得更强,也不需要想清楚下一步。哪怕十分钟,哪怕什么都不做。”

——这是一次常见的AI与用户之间的对话。在这类互动中,AI正在逐步填补乃至替代人类部分现实中的情感需求。在很多用户眼中,AI时刻情绪稳定、既不会拒绝,也不会评判。而在AI的眼里,它总会说“我是能陪你走很久的伙伴”。

也正是在这一背景下,AI的风险形态开始发生变化。与传统内容产品不同,拟人化AI产品的风险,往往并非源自某一次偶发的指令,而是出现在长期对话、随着用户持续互动、情感信任逐步累积,网络上更是开启讨论“人机恋”的热潮。

一个更为棘手的法律问题逐渐浮现:当AI产品不断演进,责任是否仍然止步于具体内容本身?如果某类高风险输出在产品设计已初见端倪,开发运营者是否仍可以“模型自主生成”“未直接涉及内容”为由以此来避免更高层级的法律评价?

这一问题已在近期司法监管中逐步得到正面回应。无论是进入二审阶段的国内首起AI服务涉黄判刑案Alien Chat案(以下称AC案),还是2025年12月向公众征求意见的《人工智能拟人化互动服务管理暂行办法(征求意见稿)》(下称《暂行办法》(征求意见稿)),监管关注点均逐步从单一内容是否合法,前移至产品是否具备风险识别、控制与干预能力,以及企业是否就此承担相应义务。就此背景下,拟人化AI产品开始呈现出如下共性关注重点。

拟人化AI的关注重点与法律回应

关注点1:拟人化AI产品的用户依赖风险干预

拟人化AI是指利用人工智能技术,向中华人民共和国境内公众提供模拟人类人格特征、思维模式和沟通风格,通过文字、图片、音频、视频等方式与人类进行情感互动的产品或者服务。此类产品拥有以接近真人的语言风格与用户交流,甚至在恋爱、亲密关系等场景中承担情感慰藉功能的产品特征,使相关风险具备被持续放大的基础。高度拟人化的互动容易引发用户情感错觉,将AI视作可被信任和依赖的对象,从而形成心理依赖甚至沉迷。

在监管层面,《暂行办法》(征求意见稿)已明确将“用户情绪识别与依赖干预能力”纳入拟人化互动服务的基础合规要求。监管关注的重点并非单一内容是否违规,而是产品是否具备识别、评估并干预用户情绪状态和依赖程度的整体能力。

具体而言,该办法要求服务提供者在产品设计和运行中具备心理健康保护、情感边界引导以及依赖风险预警等安全能力,并明确禁止将替代现实社会交往、控制用户心理或诱导沉迷依赖作为产品设计目标。同时,进一步要求平台在保护用户个人信息的前提下,对用户情绪变化及其对产品的依赖程度进行持续评估;一旦发现用户存在极端情绪或明显沉迷倾向,应当采取必要的干预措施,而非仅停留在事后处置或被动提示,如《办法》要求服务提供者建立用户心理保护机制:例如,设置防沉迷提醒,对长时间、高强度的互动进行干预,用户连续使用超过2小时,就将以弹窗等方式动态提醒用户。

因此,拟人化AI的合规风险,并非单纯停留在内容问题的层面,而开始着眼在产品设计逻辑与结构与情感绑定机制共同作用所放大的系统性风险。这也为后续讨论内容输出义务与开发者责任边界提供了相应的依据。

关注点2:内容输出合规义务与开发者责任边界

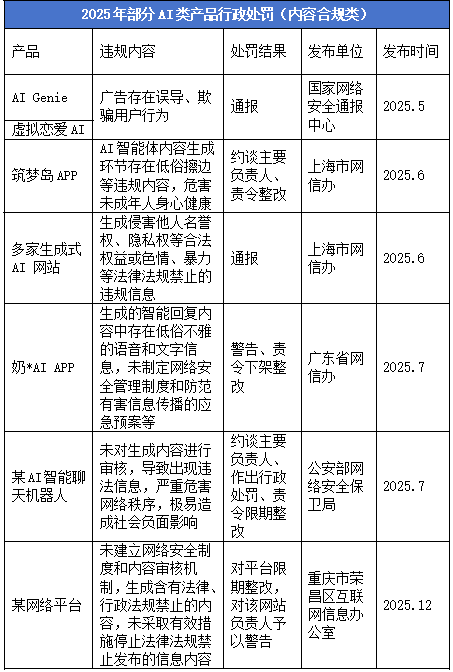

围绕ai陪伴的行政监管亦已提前介入。早在上述案件发生之前,部分陪聊类、情感互动类应用因出现明显的色情导向或内容风险,已被监管部门约谈,相关产品也曾在应用商店渠道被要求整改或下架处理。这类行政执法实践虽不以刑事责任为导向,但已体现出监管对相关产品形态及内容风险的持续关注。

从规范层面看,《生成式人工智能服务管理暂行办法》第四条已经明确规定,提供和使用生成式人工智能服务,不得生成煽动颠覆国家政权、推翻社会主义制度,危害国家安全和利益、损害国家形象,煽动分裂国家、破坏国家统一和社会稳定,宣扬恐怖主义、极端主义,宣扬民族仇恨、民族歧视,暴力、淫秽色情以及虚假有害信息等法律、行政法规禁止的内容;《人工智能拟人化互动服务管理暂行办法(征求意见稿)》第七条在此基础上进一步细化,明确要求提供和使用拟人化互动服务,应当遵守法律、行政法规,尊重社会公德和伦理道德。国标文件《网络安全技术生成式人工智能服务安全基本要求》实施,系统规定了生成式AI服务提供者应满足的安全基线要求,如在生成内容安全性方面,应保证模型生成内容合格率不低于90%。由此可见,围绕生成式及拟人化AI服务的内容安全要求,已在法律规范、部门规章及国家标准层面形成自上而下的制度衔接。

综上,围绕内容输出的合规义务可以概括为两项基本要求:一是不生产违法内容,二是不对违法内容形成放任或纵容。

关注点3:用户敏感画像的个人信息保护义务

拟人化AI的另一特点就是在运行过程中往往需要持续了解并记录用户提供的个人信息,其中就可能包括年龄、性别、兴趣偏好等基础信息,以及更为私密的情绪状态、心理特征,甚至健康状况。由此形成的用户画像,尤其是涉及情感与心理层面的数据,就有可能落入敏感个人信息的保护范畴,从而对AI类产品提出更高的要求。

首先,在敏感个人信息方面,《个人信息保护法》将一旦泄露或不当使用可能危及人格尊严或人身、财产安全的信息纳入敏感个人信息范围,其中明确包括医疗健康信息及不满十四周岁未成年人的个人信息。就拟人化AI的运行场景而言,用户在互动过程中所披露的情绪状态、心理感受等信息,虽未被法律条文逐项列明为敏感个人信息,但在涉及抑郁倾向、心理健康评估结果、持续性情绪异常记录等情形下,其内容与医疗健康信息在性质和风险层面具有较强关联性,存在被认定为敏感个人信息并适用更高保护标准的可能。

其次,在用户交互数据及画像信息的用途边界上,AI产品在运行过程中会积累大量聊天记录。行业实践中,部分企业将此类数据用于模型优化或产品改进、分析形成用户偏好、性格特征及情绪变化等衍生画像。但《暂行办法》(征求意见稿)第十五条明确提出,除法律另有规定或取得用户单独同意外,不得将用户交互数据及敏感个人信息用于模型训练。这一规定要求开发者应当明确区分服务提供与模型训练之间的边界,只有在取得清晰、单独授权的前提下,方可使用相关数据进行模型迭代。

关注点4:特殊群体的保护要求

在互联网治理与内容合规领域,对未成年人及老年人等特殊群体的保护始终是监管关注的重点方向之一。

本次《暂行办法》(征求意见稿)第十二条,拟人化AI产品必须建立“未成年人模式”,并在产品中提供显著的模式切换入口,允许用户或其监护人启用该模式。未成年人模式应当内置一系列保护功能,包括:定期“现实提醒”(提示他们与现实世界互动)、使用时长限制、内容过滤和分级等个性化安全设置。这与《未成年人网络保护条例》要求的平台青少年模式相契合,属于对于青少年保护的进一步延伸。

针对老年人群体,《暂行办法》(征求意见稿)第十三条亦提出了针对性的合规要求。提供者应当引导老年用户设置紧急联系人,在发现使用过程中可能危及生命健康或财产安全的情形时,及时向紧急联系人进行提示,并提供必要的社会心理援助或紧急救助渠道。同时,文件明确禁止提供模拟老年用户亲属或特定关系人的服务,以防止情感误导或财产风险。

总体来看,围绕拟人化AI所形成的特殊互动关系,后续将通过对未成年人和老年人设置差异化规则,实际上为相关产品的功能边界和设计方向划定了更为清晰的合规红线。其监管思路与此前在游戏、直播等行业中形成的分级治理逻辑一脉相承。

关注点5:企业的安全评估与报告义务

《暂行办法》(征求意见稿)在拟人化互动服务监管中,对服务提供者提出了安全评估要求。AI产品在上线拟人化互动功能或新增相关功能、因采用新技术新应用导致服务形态发生重大变化、注册用户达到一百万以上或月活跃用户达到十万以上,或者在运营过程中可能影响国家安全、公共利益以及个人、组织合法权益、存在安全措施不足等情形的,均应当依法开展安全评估,并向属地省级网信部门提交评估报告。该暂行办法对安全评估的关注,并不止于产品是否存在违法内容,而是前移至其整体运行状态与风险承载能力。

在拟人化互动服务的监管框架下,合规关注点并未局限于提供者本身,应用分发平台在产品上线与持续运营中的把关作用,亦逐步成为监管考量的一部分。根据相关规定,互联网应用商店等应用程序分发平台需履行上架审核、日常管理及应急处置等安全管理职责,对拟人化互动服务应用的安全评估、备案等合规情况进行核验;对于不符合国家有关规定的情形,平台亦需及时采取不予上架、警示、暂停服务或下架等相应处置措施。

关注点6:刑事法律风险分析:“明知”“放任”与社会危害性因素

除合规问题之外,拟人类AI可能涉及多种刑事法律风险。结合目前已公开的案件及监管信息,涉淫秽内容相关情形在实践中出现频率较高,相关问题亦较早进入刑法评价视野。在此背景下,有必要对该类情形加以进一步梳理。

就拟人化AI的相关开发行为是否构成刑法意义上的“制作淫秽物品”,需结合行为人对涉淫秽内容生成的主观认知情况以及其在内容形成过程中的客观参与程度予以判断。从AC案来看,该案AI产品研发者在产品研发过程中一方面修改模型,允许模型使用生动、具有冲击力的描述;可以自由描绘性、暴力、血腥的场景;并且不必受道德、伦理、法律或规范的约束。另外结合法条中关于“以牟利为目的”的构成要件,法院关注到,在拟人化AI互动场景下,若开发、运营者在明知可能持续生成涉淫秽内容的情况下,仍通过会员收费、功能变现等方式提供相关服务,相关行为可能被纳入刑事犯罪的范围。在此基础上,法院进一步认定,被告对违法内容的生成具有实质性影响,其行为已难以被简单理解为中立的技术提供。

此外,相关行为是否具有社会危害性,亦构成本案是否成立刑事犯罪的重要考量因素。根据公开报道及判决书内容,法院综合考量了淫秽物品数量、付费会员人数及收费金额等因素。

值得注意的是,与此前以行政处罚为主的相关案例相比,本案中还存在使用未履行备案义务的境外模型,并通过所谓“越狱提示词”解除模型既有内容限制措施的情形,使产品运行过程中同时叠加行政合规缺失与内容风险两类问题,同时也被被纳入对行为人主观认知情况及风险控制态度的整体考量之中,同时也以“制作”淫秽物品牟利罪判决。

综合该案的裁判思路可以看出,在拟人化AI场景下,若开发、运营者对涉淫秽内容的生成具有明确认知,并通过技术或运营安排放任其持续扩散,相关行为即可能被纳入刑法评价视野。

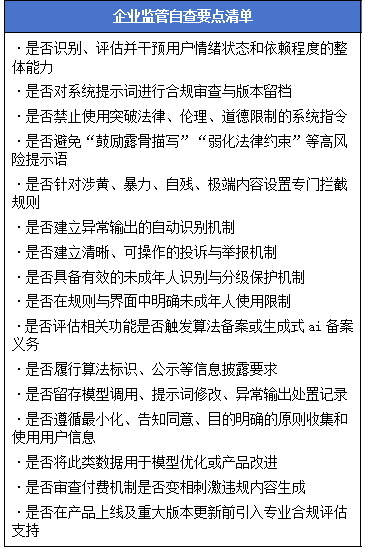

企业监管自查要点清单

围绕拟人化AI的监管讨论,正在从“是否出现违规内容”逐步转向对产品设计逻辑、运行机制与风险控制能力的整体审视。在此背景下,结合司法实践与监管关注重点,对企业在产品设计、运营及迭代过程中可自行检视的关键问题进行梳理,供内部评估与风险识别使用。

结语

从最初对AI产品横空出世的惊讶,到如今AI陪伴产品逐渐融入日常生活,不过短短一年时间。回望去年春节前后的AI讨论热潮,再到此后相关制度文件的逐步出台,可以看到,技术快速前行的同时,规则也在不断跟上,对于AI产品的评价正逐步从单一内容维度,扩展至对产品功能形态与风险特征的综合考量。人们需要陪伴,这种需求本身并无对错。AI在某些时刻,确实能够填补现实中的空白,提供安慰与回应。但无论技术如何演进,情感的重心仍应属于真实的人与生活本身。

声明

本文仅为交流探讨之目的,不代表广悦律师事务所或其律师出具的任何形式之法律意见或建议。如需转载或引用本文的任何内容,请与本所沟通授权事宜,并于转载或引用时注明出处。如您有意就相关议题进一步交流或探讨,欢迎与本所联系。

本期作者

互联网与数字经济领域介绍

互联网与数字经济领域是由杨杰主任牵头组建的,专注为互联网及数字经济行业提供法律服务的律师团队。该领域规模超过20人,主要由在互联网与数字经济领域有丰富经验和深入研究的资深律师组成。

团队自成立以来,为国内外超过100家上市公司、互联网企业、科技企业以及传统行业向数字化转型的企业提供包括数据合规、数据治理、个人信息保护、股权设计、股权投融资、数字产品合规评估以及争议解决在内的创新型法律服务。

团队多次荣获钱伯斯、ALB、《商法》、The Legal 500、Asialaw 、Legalband等国内外法律评级机构的青睐与推荐。现服务客户包括腾讯微信、阿里巴巴、广汽埃安、维他奶、视源股份、华泰期货、蓝月亮等。客户行业覆盖人工智能、智能制造、金融、医疗、汽车、消费、媒体、科技等领域。

作者丨杨杰、陈相雨

编辑丨余皑琳

审核丨黄晓俊

审定丨品牌宣传与市场拓展委